Geteilte Autos

Bundesverband Carsharing

Bundesverband CarsharingDie Vorteile liegen auf der Hand: Mit Car-Sharing lassen sich Kosten sparen. Das ist gut für den, der es nutzt. Car-Sharer fahren im Durchschnitt um 50 Prozent weniger Auto. Das wiederum ist gut für die Umwelt. Trotzdem ist Car-Sharing in Österreich noch kein rechter Erfolg beschieden.

Ein Blick in unser Nachbarland Schweiz zeigt, wie es funktionieren kann. Dort teilen bereits mehr als 80.000 Mitglieder oder Kunden der Genossenschaft Mobility, die an über 1000 Standorten 1950 Wagen anbietet, das Fahrzeug miteinander. Nach kurzer Voranmeldung via Telefon oder Internet kann jedes Mitglied diese Autos nutzen und zahlt nur die Kosten, die für die Fahrt anfallen. Innerhalb von zehn bis 15 Minuten soll man an einem Standort sein.

In Österreich gibt es derzeit 16.000 Nutzer und 200 Standorte des Anbieters Carsharing.at, vormals Denzeldrive und jetzt ein Joint Venture von der Schweizer Mobility und Denzel. Im nächsten Jahr soll das Angebot um 15 Prozent erhöht werden. Vielleicht hilft das, dass Auto-teilen auch in Österreich attraktiver wird. Denn die Anwendung ist es bereits.

Reservieren und losfahren

Hat man sich für Car-Sharing angemeldet, können Buchungen zu jeder Tages- und Nachtzeit über das Internet oder telefonisch getätigt werden. Die Autos werden per SMS freigeschaltet. Steht man vor dem Auto, braucht man nur seine Karte mit integriertem Funkchip gegen den Empfänger an der Windschutzscheibe halten und – „Sesam, öffne dich“. Der Bordcomputer zeigt die Reservierungsdaten an, die Zentralverriegelung öffnet. Fahrzeugpapiere und -schlüssel liegen im Handschuhfach. Dort findet man auch, falls notwendig, die Dauerparkkarte für die jeweilige Garage.

Unterbricht man die Fahrt, wird das Fahrzeug einfach mit der Karte wieder geschlossen. Das funktioniert tadellos und einfach. Einige Bedenken, die sich bei unserer Testfahrt einstellten, erwiesen sich als unbegründet. Man bekommt monatlich eine Rechnung, auf der minutiös jede Fahrt aufgelistet wird. Die Rechnung wird entweder per E-Mail oder in Papierform zugestellt. Einzig die nächste Station lag bei unserer Probefahrt deutlich weiter entfernt als die maximalen 15 Minuten in der Schweiz. Schade. Aber was nicht ist, kann ja noch werden.

Was jedoch positiv ist, ist die Auswahl an fahrbaren Untersätzen. Zwar sind die meisten Standorte nicht gerade üppig bestückt, aber an den großen Bahnhofsstationen stehen auch Kleinbusse für den Transport großer Gegenstände zur Verfügung.

Nachgerechnet

Die Beträge auf der zugesandten Rechnung sind gefühlsmäßig verschmerzbar. Man hat ja immer im Hinterkopf, dass Kraftstoff, Servicekosten, Reifen und einfach alles eingerechnet sind. Die Experten vom Verkehrsclub Österreich (VCÖ) hingegen haben genau nachgerechnet.

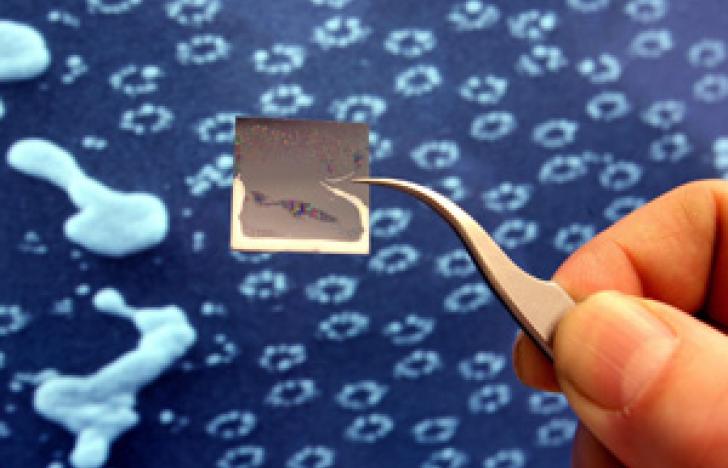

Wer weniger als 12.000 Kilometer im Jahr fährt, ist so billiger unterwegs. Bis zu 100.000 Menschen könnten in Österreich auf Car-Sharing umsteigen, hat der VCÖ errechnet – dadurch wären auch weniger Autos unterwegs. Car-Sharing bedeute zudem einen bewussteren Umgang mit dem Auto. Car-Sharing-Wagen werden um 50 Prozent weniger benützt als der eigene. Damit ist der CO2-Rucksack um 1300 Kilogramm leichter. Der durchschnittliche Car-Sharing-Nutzer legt zwei Drittel seiner Wege mit öffentlichen Verkehrsmitteln oder dem Fahrrad zurück. Ausschlaggebend für die Wahl sind aber weniger Geld- als vielmehr Umwelt-argumente, denn das Einkommen eines Car-Sharers liegt über dem Durchschnitt. Foto: Bundesverband Carsharing